Estimation de l'exposant de Hölder par Programmation Génétique.

L'estimation de l'exposant de Hölder peut être assez coûteuse, notamment sur les signaux de grande dimension et pour les grandes images. Il était donc pertinent d'essayer de trouver une méthode simple et rapide pour pouvoir envisager des applications en temps réel. L'idée est de construire par programmation génétique un nouvel estimateur de la régularité Hölderienne. Pour cela, en collaboration avec Léonardo Trujillo et Jacques Levy-Vehel, nous avons construit un ensemble d'image avec des régularités prescrites avec la toolbox FracLab (dont je contribue au développement depuis 2000) puis nous avons conçu un GP afin de construire une fonction calculant instantanément un estimateur de l'exposant de Hölder en chaque point d'une image. On utilise ce GP pour chercher des opérateurs qui minimisent l'erreur d'estimation pour chaque régularité prescrite.

Les estimateurs évolués, proposés pendant l'execution du GP, sont testés sur un nouvel ensemble d'images, dont on maîtrise la régularité Hölderienne (évoluant comme un sinus ou une exponentielle selon les axes). Les résultats expérimentaux montrent que l'estimateur obtenu à la fin du processus produit une bonne estimation de l'exposant de Hölder, d'un point de vue quantitatif et d'un point de vue qualitatif. En effet, l'estimateur obtenu surpasse la méthode par oscillation d'un ordre de magnitude. De plus, on constate que l'algorithme GP est capable de produire des estimateurs qui fonctionnent très bien au cours des tests. Enfin, la vitesse d'application de l'estimateur obtenu a permis pour la première fois de pouvoir estimer et d'afficher en temps réel la régularité Höldérienne d'une vidéo pendant son acquisition.

Ces travaux [GECCO10_GPHOLDER] ont reçu le Best Paper Award lors de la conférence GECCO 2010 à Portland, Oregon.Projet IRSES ACOBSEC :

Projet Européen Acobsec : des algorithmes évolutionnaires, de la programmation génétique, de la régularité Hölderienne et du traitement du signal sur des signaux biomédicaux.

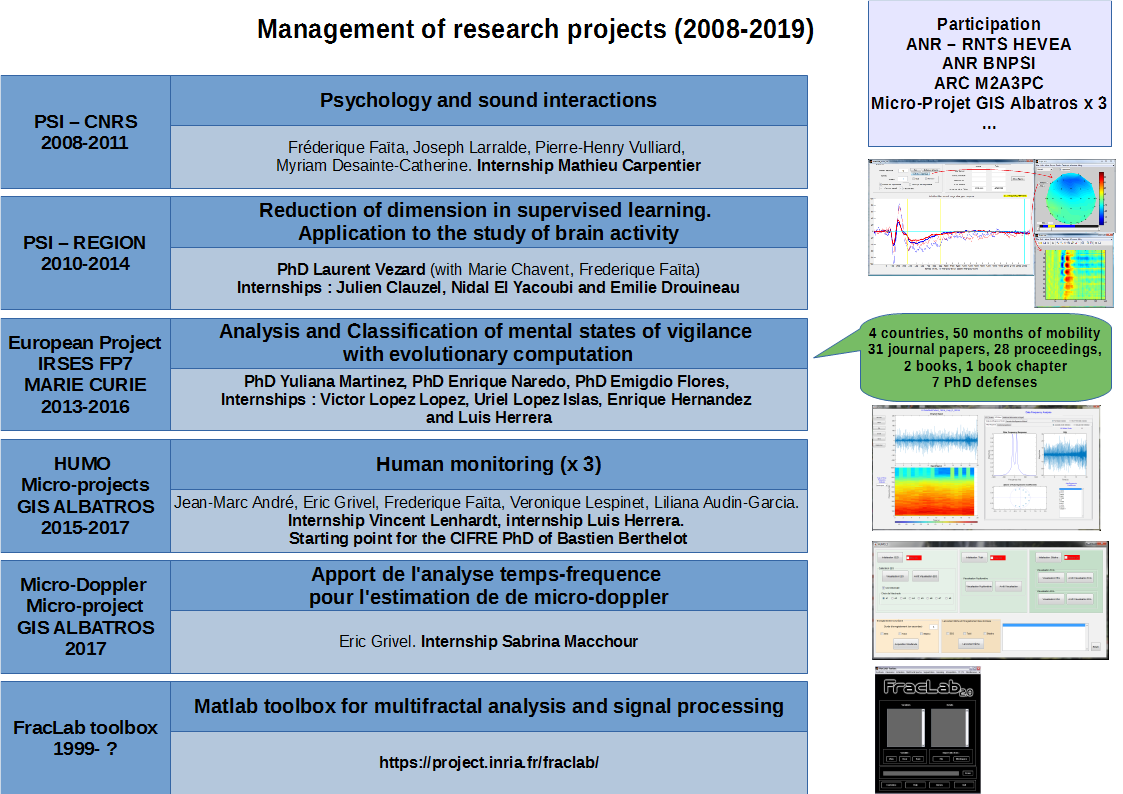

Le projet FP7-PEOPLE-2013-IRSES Marie Curie 612689 (2013-2016) ACOBSEC, "Analysis and Classification of mental states of vigilance with evolutionary computation", dont j'étais le porteur et le coordinateur scientifique, a démarré officiellement en novembre 2013, a permis de financer environ 50 mois de mobilité pour des étudiants et des chercheurs Mexicains, Portugais, Espagnol, Français et a généré la production scientifique de 31 article de revue, 2 livres, 28 articles en conférence avec publication des actes et 1 chapitre de livre. 9 thèses ont aussi été associées à ce projet.

L'objectif de ce projet était de développer de nouvelles stratégies de recherche et d'optimisation, basées sur l'évolution artificielle et la programmation génétique pour la synthèse automatiques de classifieurs efficaces et précis. L'évolution artificielle et la programmation génétique sont des techniques qui peuvent obtenir de bon résultats dans des espaces hautement multi-modaux, non-différentiables et discontinus. Et c'est le cas pour le problème traité ici : La détection des états de vigilance. Ce projet a combiné les expertises de partenaires de recherche de 5 champs convergeant : La classification, les neurosciences, le traitement du signal, l'évolution artificielle et la parallélisation et provenant de France, du Portugal, d'Espagne et du Mexique. Les partenaires impliqués ont permis une forte collaboration multidisciplinaire autour de ce projet.

[Final Report]EEG et vigilance :

Classification des états de vigilance de l'humain par classification de signaux EEG : du traitement du signal, de la classification et un algorithme évolutionnaire.Dans le cadre de la Thèse de Laurent Vezard il était question de construire un modèle capable de prédire l'état de vigilance d'un humain à l'aide de son activité électrique cérébrale recueillie via un casque à 58 électrodes. Ce modèle avait pour but de pouvoir être utilisé dans des applications en temps réel. C'est pourquoi, il était important de remplir les objectifs suivants :

- Réduire le temps nécessaire pour installer le casque à électrodes sur un sujet, en utilisant une méthode de sélection des variables afin de choisir la meilleure électrode (fondée sur le taux de bons classements). En effet, dans les applications réelles, il est important de limiter le nombre d'électrodes utilisées afin de réduire le temps nécessaire à l'installation du casque et le coût du matériel (casque EEG en particulier). Une longue mise en place du casque EEG pouvant aussi entraîner une perturbation de l'état mental du sujet.

- Obtenir un modèle (règle de décision) capable de donner une prévision fiable de l'état de vigilance d'un nouveau participant.

Pour atteindre ces objectifs, des caractéristiques ont été extraites du signal EEG afin de simplifier la tâche de classification. Une nouvelle contribution, fondée sur l'utilisation d'une décomposition en ondelettes discrète a été proposée afin d'extraire un critère de discrimination de l'état de vigilance. Plusieurs méthodes usuelles de classifications supervisées (les arbres binaires de décision, les forêts aléatoires, ...) ont été utilisées pour prédire l'état de vigilance des sujets. Enfin, le critère a été ensuite affiné à l'aide d'un algorithme génétique pour améliorer la qualité de la prédiction [Vezard_Legrand_2012] [Legrand_Vezard_2014] [Vezard_Legrand_2015]. Ce travail a permis d'obtenir un taux de bon classement moyen de 86.69+-1.87% sur des données réelles et de sélectionner une electrode parmi les 58 initiales.

Projet HUMO : HUman MOnitoring

Le projet HUMO (HUman Monitoring - Approche interdisciplinaire de l'évaluation de l'état cognitif de l'utilisateur) visait à valider un protocole de recueil, traitement, et interprétation des données physiologiques pour l'évaluation de l'état de charge cognitive de l'utilisateur (crew monitoring).

Ce projet se situait à l'interface du thème interaction homme système et du thème signal et image au sein du GIS Albatros. Ce projet a fédéré des experts issus de différents champs disciplinaires, de différents laboratoires ou centres de recherche du campus Bordelais.

Dans le cadre de ce projet, j'ai pu, par exemple, concevoir un nouveau logiciel pour l'acquisition simultanée de multiples capteurs sous Matlab (EEG, ECG, EDA, PUPILLO). Ce projet m'a aussi permis de co-encadrer avec Eric Grivel (IMS) le stage ingénieur Enseirb, puis le CDD de Vincent Lenhardt et enfin d'obtenir le financement de thèse CIFRE de Bastien Berthelot.

[Report]Cifre Orosys : Real-Time Nonlinear Audio Effects Modelling with Neural Networks

Virtual analogue modelling is the process of applying digital signal processing techniques to simulate analogue musical circuits such as those found in vintage vacuum tube amplifiers or effects pedals. This work, performed in the Cifre thesis of Tara Vanhatalo with the company Orosys, describes a new approach for this simulation task via the use of neural networks.

In order to be heard, especially in a live setting, electric guitar signals need to be amplified to an acceptable volume. Before the advent of the transistor, this kind of signal amplification was accomplished using vacuum tubes and in the case of guitar amplification, this is still the preferred method as guitarists tend to prefer the sonic characteristics of this technology.

However there are a number of downsides to vacuum tube amplifiers which include elevated cost and weight, fragility (and subsequently component rarity), they are also cumbersome and the sound can vary from one amplifier to another depending on the component values of the circuit, even when it comes to the same make and model.Digital emulations circumvent these downsides and allow us to recreate, and thus also preserve, rare amplifier models. However, the simulation methods that currently exist also present a certain number of downsides depending on the type of simulation method employed. Three class of method exist for this modelling task: white-box, grey-box and black-box. The nomenclature of these methods indicate the degree of knowledge (of the device circuitry) necessary for the emulation.

White-box methods necessitate study of the amplifier circuit's component values and placement in order to establish a system of ODEs to be solved iteratively. This results in an emulation that is either computationally slow or that introduces inaccuracies due to simplifications often used for faster processing. Moreover, even a highly accurate white-box model will often not mimic a given device perfectly. This is due to the component values used that are either theoretical or measured that can introduce inaccuracies in the resulting simulation. Finally, these methods are very labour-intensive to put in place.

Black-box models are much simpler to implement than white-box ones as they are essentially system identification methods in which input-output measurements are used to optimise a given model. This also means that the emulation of any given device will be more accurate and we'll be able to replicate each amplifier's idiosyncrasies.

Grey-box methods fall in between the two previously described approaches. They usually comprise simplified topologies inspired by the device circuitry but optimised with input-output measurements.

Neural networks lie in the black-box category and are particularly well-suited to modelling very nonlinear behaviour due to their multi-layered nature and nonlinear activation functions. They therefore seem well suited to this emulation task.

There exist a number of factors specific to this modelling task. The first one is the real-time constraint. Indeed, real-time processing is a key factor to consider in this task as it necessary to minimise latency in order to not hinder a musician's playing. Maximum acceptable latency allowed is around 10ms. Latency over this can be perceived by the musician and create a psychoacoustic effect resulting in them gradually playing slower as they wait for the next note. These 10ms aren't reserved exclusively for the processing by the neural network, other sources of delay are also present and include, for example, the Analogue to Digital Conversion (ADC). In neighbouring fields such as speech processing, sampling rates of 16 or even 8 kHz are often sufficient for acceptable audio quality. This isn't the case in music where the lower bound for acceptable quality is 44.1 kHz. These high sampling rates increase the strain on the real-time constraint.

Digital processing of audio often falls prey to aliasing due to the sampling required in the ADC. Aliasing arises when a sampled signal contains frequencies exceeding the Nyquist frequency $\bigl(=\frac{\text{sample rate}}{2}\bigr)$. The frequencies exceeding the Nyquist rate are reflected back into the baseband in the form of aliases, resulting in undesired audio artefacts in all frequency ranges. The nonlinear effect we wish to recreate with neural networks creates harmonics and thus is very prone to aliasing. Oversampling is usually used to overcome this but this adds an ever bigger strain on the real-time constraint.

A number of architectures exist for audio effects modelling. Those that show the best performance and are capable of real-time processing fall under two classes: recurrent neural networks which are tailored to sequence processing and are able to emulate the dynamic behaviour thanks to their recurrence; and convolutional neural networks which use static input buffers that contain the necessary past information for the dynamic modelling \cite{Wright2020}.

Until recently, recurrent models have shown an advantage over convolutional ones as their recurrence allows for small input buffers which make them well suited to low-latency processing. The convolutional models used most commonly for this task can be adapted to smaller input buffers which makes them a promising alternative candidate to the recurrent models. Autoencoders have also been applied to this modelling task but most architectures are incapable of real-time processing. However RAVE, a variational autoencoder for audio synthesis is capable of real-time performance with sampling rates up to 48 kHz, has also been used for timbre transfer \cite{Caillon2021}.

The wide variety in hyperparameters and training data used in the state-of-the-art of neural networks for audio effects processing makes their direct comparison difficult. Therefore, we present a formal comparison of these architectures in a review article \cite{Vanhatalo2022}. Once an appropriate architecture had been identified and optimised, we were able to create an emulation that accurately models the behaviour of a number of amplifiers. This model has been incorporated into a prototype capable of real-time use, coded in C++ for fast inference on consumer-grade CPUs.

One of the elements we have studied is the aliasing present in the state-of-the-art architectures. We evaluate various methods of reducing aliasing and study two example architectures (one convolutional and one recurrent) in order to determine what the exact causes of the aliasing is as aliasing can even be present when oversampling methods are used. We are currently writing an article on this study.

A study on the benefits of transfer learning and how to proceed with the transfer has also been carried out. The starting model is chosen via feature extraction and various datasets for the fine-tuning are compared. This study is also the subject of submitted article.

[NNA_AMPLI_EMU_COMPARISON]Plan de relance Thales : détection d'outliers en mer Méditerranée

Ce projet s'inscrit dans le cadre d'un plan de relance entre l'IMB, l'IMS et le partenaire industriel Thales DMS et a permis le recrutement de l'ingénieur Lucas Steffanutto pour 2 ans.

À l'heure ou le trafic maritime s'intensifie un peu plus chaque année, avoir une bonne compréhension des patterns et routes empruntées par les navires est un atout majeur dans un contexte de surveillance maritime. Certaines parties du globe telles que la mer Méditerranée se prêtent idéalement à cet apprentissage, dans le but de déceler des anomalies comportementales. Elles peuvent être le résultat d'une situation de détresse ou bien d'activités illégales : pêche, trafic d'armes, trafic de drogues, migrants etc. L'itinéraire d'un navire peut être suivi grâce à l'émission régulière de messages de son Système d'Identification Automatique (AIS - Automatic Identification System). Ces messages indiquent sa position, sa vitesse, sa direction et d'autres précieuses informations au cours du temps. Néanmoins, la mer Méditerranée est une zone d'intérêt immense, et le nombre de bateaux y circulant simultanément est énorme. Un ou plusieurs opérateurs de surveillance maritime ne peuvent pas traiter simultanément toutes les pistes AIS. Le but de ce projet est donc de développer un système de détection d'anomalies à partir de données AIS et Radar pour détecter une activité illicite ou une situation de détresse.

L'état de l'art des méthodes de détections d'anomalies a été réalisé, ainsi que son application aux données AIS. Une base de données de messages AIS réels fournie par Thales a été enrichie à partir de scraping et de dictionnaires, pour nous permettre d'utiliser des données AIS complètes. Ces données correspondent aux messages AIS en mer méditerranée entre 2019 et 2020 (environ 100 Go). Elles ont pu être visualisées grâce à l'utilisation d'outils logiciels tels que Elasticsearch et Kibana. D'après les recherches effectuées, la solution état de l'art GeoTrackNet a été choisie comme base pour la problématique et les données à traiter. Cette architecture regroupe un réseau de neurones permettant d'apprendre la représentation probabiliste des patterns maritimes d'une zone d'intérêt à partir d'un flux de données AIS, ainsi qu'un module de détection d'anomalies « a contrario » basé sur le nombre de fausses alarmes.

Des modifications de ce système ont été implémentées de manière à pouvoir utiliser une quantité de données plus importante. De premières détections de comportement anormaux ont été obtenues en mer Méditerranée, à partir d'un apprentissage de 3 mois de données.

Projet PRAETORIAN "Rock around the space" Diffusion sonore multicanaux Applications sur deux oeuvres du groupe PRAETORIAN

En partenariat avec le Scrime, développements informatiques réalisés avec Robin Montferme et Joseph Larralde.Objectif : Améliorer l'expérience d'écoute d'un morceau de musique. Assis dans mon canapé, dans mon salon, j'aimerais pouvoir placer les divers instruments du morceau de musique que je suis en train d'écouter, tout autour de moi, modifier virtuellement leur distance, enregistrer ma configuration préférée pour chaque morceau, etc.

Puisque la plupart des enregistrements audio actuels sont réalisés piste par piste en studio, il serait facile au éditeurs de généraliser la vente de produits multipistes. On découvre via ces travaux quel serait le rendu.

Exposé/Démo à la salle Hémicyclia le 26 janvier 2023